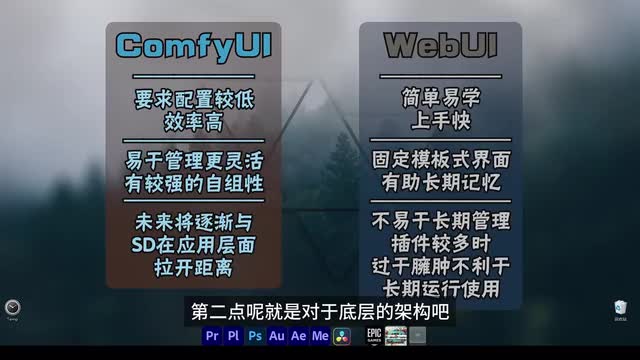

hello, 大家好,这一期我们终于迎来了咖啡u i的正式系列教程了。那么首先要说的第一点就是咖啡u i和s d web u i之间的区别有哪些呢?那在这方面第一点我们直观的能感受到的其实就是速度的提升。对于咖啡u i来说,我们可以自由的搭建一套优化的这么一个工作流,来节省我们额外运算和挂载相关功能组件的这么一些时间。工作效率大概是要比s d提高百分之三十左右。第二点呢就是对于底层的架构吧,我们可以把s d呢当做一个已经固定了工作流的咖啡ui比如说我们文生图和图生图,又或者是后期放大等等。这些板块和模块呢其实都可以对等的理解为conf ui当中固定的一套工作流。那么易于新手使用的原因就是我们不需要考虑其他的问题,只需要在web u i里面需要输入参数的地方,正确的输入我们的参数,就可以正常的生成图片了。

而咖啡u i呢我们其实是可以灵活地组建不同的工作流,并且把这些工作流拼接到一起,甚至是可以灵活地进行组装和拆分的。那么对于咖啡u i这种节点式的。编辑模式呢其实对于曾经很多专业的传统软件都采用过这样的模式。在视频后期领域呢,比如达芬奇的fusion,又或者是milk。那么在三d领域呢也有blender的材质渲染界面,又或者u e当中所有的系统其实都是用节点的思路进行构建的。其实这种方式呢除了灵活之外呢,它更主要的是对于专业团队的一种需求。因为专业团队是需要多人协作的,节点式的方式呢是很容易实现这个模块化拼接和组装的。

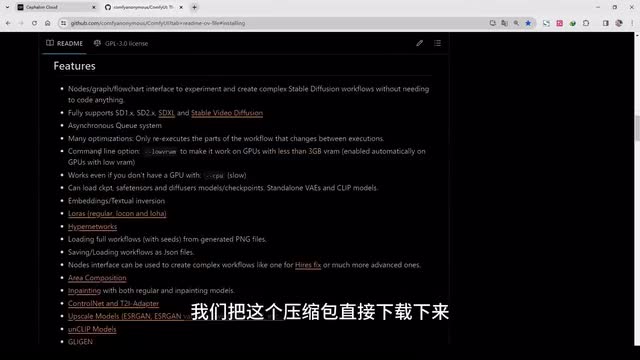

所以这才是专业团队一般都选用这个节点式编辑的主要原因呢。那在抗非u i对我们个人而言或者社区而言呢,其实它起到的作用就是更容易进行分享。我们通常都可以把别人现成的工作流导入到我们的p u i的界面里面来,又或者是把某一个功能模块分享出去。那么这一方面呢我觉得才是节点它最大的作用和效果。ok那么简单的了解完以后呢,我们就来进行初步的安装和配置。其实这个过程非常的简单,在这里呢我们也打开了一份咖啡u i的github,其实作者都已经为我们准备好了这个压缩包了。那可以看到这个是对于。

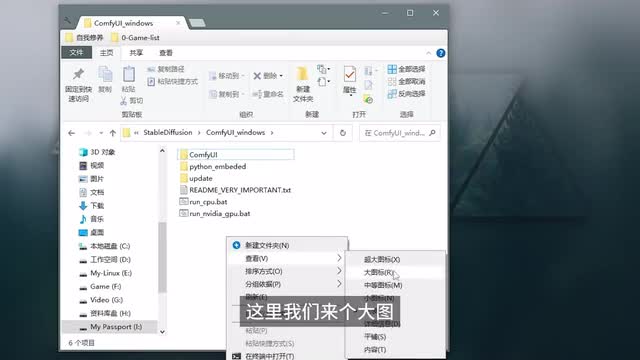

温系统的一个压缩包,我们只需要下载这个压缩包并且解压,就可以在我们本地使用了。那么在配置方面呢,我建议最低是四g的显卡,一定要是nvidia。如果是a m d的显卡呢,我们就需要用linux的系统了。所以目前对于任何a i神经网络的项目呢,都是要靠n卡进行实现的。啊,那么我们这里主要讲的是windows系统,我们把这个压缩包直接下载下来,这里我们简单的做一下安装示范啊,这里我已经下载好这个web u i的压缩包了,重新命个名吧,就叫web u i windows一个七z的压缩包。我们直接把这个压缩包右键解压,解压完以后我们点击文件夹啊,可以看到这里他还是套了一个文件夹,我们可以把它再再把它剪切出来。这样的话我们是一级目录啊,然后我们直接点进来。

本质上来说呢,我们现在已经就安装完成了,就这么简单,解压了以后就安装完成。那么接下来我们需要简单的了解一下它的文件结构和做一些简单的配置。首先我们看第一个文件夹conf u i,这里我们来个大图标。第一个conf u i呢那么就是它的一个文件目录了啊。那么第二个呢可以看到这个python的变。这是给我们已经预制好的一个python环境。其实我们运行conf u i是在这个便携版的python这个环境里面运行的。

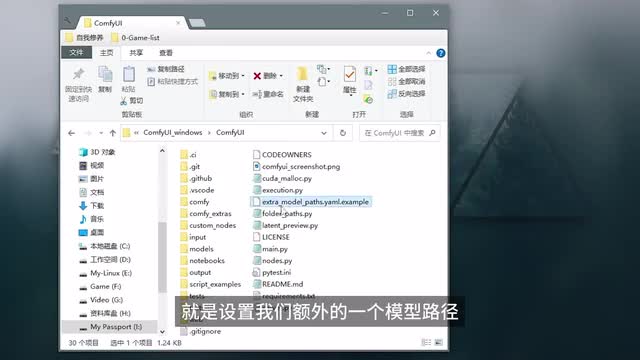

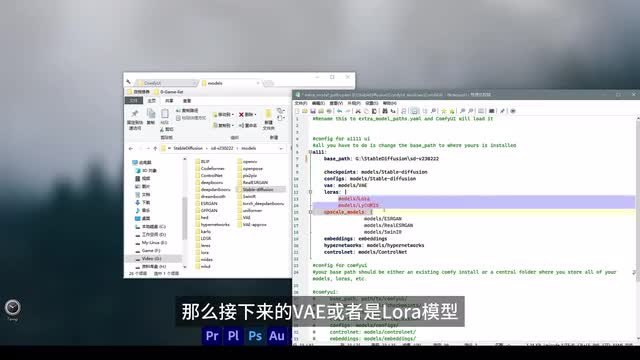

那么第三个是app date,可以看到就是相关的升级文档。当我们需要升级更新我们这个c p u i的时候,直接update就可以。那么其实这里呢我们也可以不需要这么执行啊,之后我们用一个比较便捷的工具来进行项目的管理。那么接下来我们说到的就是一个简单的路径配置了啊,我们进到conf u i的文件夹里面来,在这个文件夹里我们可以找到这样一个文件,extra model path, 就是设置我们额外的一个模型路径。后缀名呢其实这个是a m l,后面呢它其实这个地方给了我们一个这个样本,这只是一个样本文件,它并没有正式起作用。要让它起作用的话呢,我们需要把后面的这个删掉,把这个点都删掉啊,只用y a m l做后缀。然后我们右键用编辑文本的方式把它打开,在这里就可以看到,可以设置一些它的路径。

如果我们电脑曾经安装了s d的话,其实是可以把模型路径设置到s d的模型路径文件下的那这样的话我们就不需要下载两。模型或者是复制多份模型来产生额外的空间占用了啊。首先第一个我们可以设置一个基本的pass,就是s d的根目录在哪里?我们这边的根目录是在这里啊,那么我们就可以直接复制我们这个根目录,然后放在这个地方,它就识别到我们s d的根目录了。之后呢自然可以查找到check point主模型的路径,也就是在我们这个根目录下的models,然后stable division这样一个路径,对不对?那么接下来的v a e或者是laura模型也都是在model下面的,对不对?还有下面的放大模型impacting,还有happy net work,这都是对应的那这里要注意的是,这个control net这个地方的模型映射的是不对的,对不对?我们的control的模型一般是在根目录下面的这个拓展文件夹extensions这么一个拓展文件夹下,然后找到control在这个里面的models。所以说这才是我们control net的模型。那么这样的话呢,我们是需要把这个路径呢指定到这个地方来,也就是我们根目录之后的位置,我们放到这里来,这个位置是对的啊,所以这里如果我们要做映射的话。就修改一下这个文件,然后我们直接点击。

关闭保存。这样的话咖啡u i的配置呢就会识别我们s d下面相应的模型目录了。那么这是在我们曾经电脑有装过stable division web u i的情况下,进行这个模型路径的安装。如果没有呢,我们就可以不需要改动这个文件啊,它是什么样还是什么样。那么我们默认的路径呢就是在conflict的根目录下。mode一样的啊,进来以后呢一样能看到check point主模型。然后再往下呢什么happy night world抄网络,又或者是这个embedding嵌入模型laws对吧?又或者v a e在这里都有,或者是scale的模型放大模型。

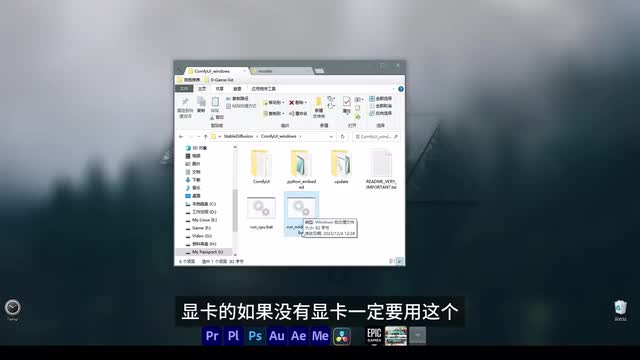

所以之后的模型基本上都是下载到这个地方。它自动识别的是这个默认路径,包括control net。当配置好以后,直接运行这个run就可以。这里的run有两个,第一是这个nvidia显卡的。如果我们有显卡一定要用这个,没显卡那么就用这个c p u了,可能会慢一点啊。那在这之前呢,我们一步到位,我们再安装一个小的插件。这个插件呢主要就是管理更多插件的一个插件,说的有点绕啊。

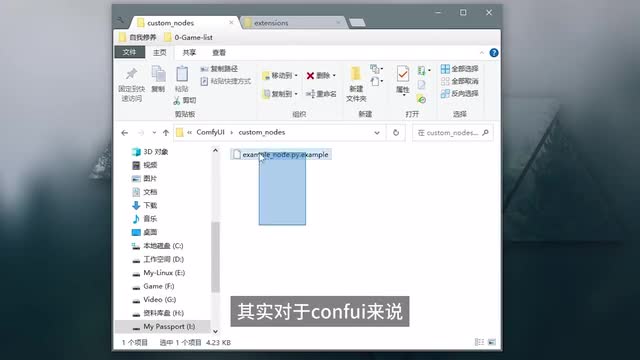

那么说到这儿呢,我们就说到第二点,如何安装。conf u i的插件。同样我们来到conf u i的文件夹下面,像在s d安装插件我们们也都知道了啊,在我们这个extensions拓展里面对吧?如果是在web u i里呢,我们找到下面有一个custom notes自定义节点。其实对于conf u i来说,所有的插件呢大部分的插件都是额外的一些节点。不同的节点为我们提供了不同的功能。当我们想调用更多的功能,但是线性框架下没有这些功能的话怎么办?我们就需要下载额外支持这些功能的节点。所以在这u i里面我们这个插件或者是拓展文件夹,它叫custom notes。

ok明白这一点以后呢,我们就要来安装这样一个manager的一个插件。我们可以看一下它的github,那在这里呢我们可以看到它主要是为了方便管理我们整个的一个插件的组。包括检测我们当前的模板是否有丢失的插件。同时呢自动更新插件、安装插件、整合插件,它是一个很方便的一个工具。可以看到这里,我们可以搜索任何想要的插件,直接在这个地方安装就好了。那怎么安装呢?对于插件的安装,我们有两种方式。第一种方式呢,最简单的,我们来到插件相应的github网站,然后点击code代码下载它的压缩包。

然后把这个压缩包解压到我们刚才说的这个custom note里面就ok了,这就是最简单的。那么第二种方式呢,相对程序员一点,我们点到custom这个note这个文件夹里啊,然后我们调出来c m d或者power shot。我们这里c m d比较简单啊,然后在这个地方呢我们进行项目的拉取。那这样的拉取方式呢也都是从我们这个github直接拉取的。我们复制一下这个网页。所以相信大家知道啊,这样是需要进行一个网络配置的,不然我们拉取不了,对不对?既然是从github拉取之前,我们是需要安装这个get这么一个库的啊,这样的话我们的后台才支持git kon这样的命令,然后我们这里直接打git。嗯,然后空格放入我们刚才复制的这个giu p的网页网址,直接回车。

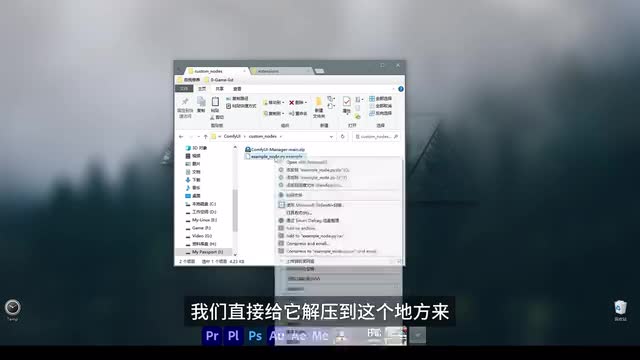

那么这里就可以看到它直接就把源码把这些源码全部下载到我们这个文件夹了。这是比较程序员的一种方式,可以看到这已经下载下来了o k如果没有配置网络的情况下呢,我们把它删掉。那么就是直接找到我们下载的这个压缩包,放到我们这个地方来,然后粘贴到这里,我们直接给它解压到这个地方来,那么这个效果啊是一样的。但是这个名称呢,我们需要改一下,不是这个命。我们把这个命删掉啊,就是这样的一个默认名称,和我们刚才clone的这个文件夹是一样的。那可以看到这里套了一个文件夹,我们还是要把它挪出来。这个文件结构一定不能错啊,一定是这样。

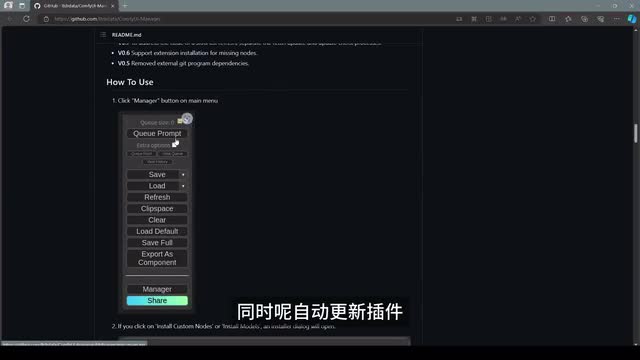

这样的话和刚才的内容是一模一样的那所以对于网络有问题,不方便下载这个插件的朋友们的,那么每一期呢未来都会把这个压缩包放到我整合的网盘里。大家需要哪些插件都可以直接下载这么安装,不需要直接clone,直接从这个github拉取了。这样的话是需要网络配置。那么明白这一点就可以,这就是第二点插件的安装。当我们安装好这个插件以后,我们就可以正式的启动com u i了。这里我们直接run这个nvidia gpu加速的方案双点啊,那么后台呢就已经打开了啊,我们稍微等待一段时间啊,copy i就顺利的打开了。打开以后它会给我们默认的加载这样一个文生图的功能模块啊,这里我就不叫工作流了,我们叫功能模块,因为这远远不到一个工作流的标准啊,那么第三点我们要说的就是如何通过我们刚才安的这个manager的这么一个插件来管理或者是安装。

其他的插件旁边可以看到这有一系列的按键指令啊。我们只要需要按住control,然后推滚轮,我们可以把它缩小一点点,放在旁边进行一个浮油窗这样一种方式,这是我习惯这样做啊,可以看到下面有个manager,这就是我们刚才安装这个插件的功能,它就会多这么一个选项了。那我们点开它以后可以看到一些相应的功能。就比如说安装插件,安装模型,然后升级我们的conf u i或者是升级所有的内容,那这就是它的一个便捷性了。那么接下来我们再安装插件,就可以通过这样的方式来安装了。比如说我们选第一个install custom notes,安装自定义的节点,也就相当于安装插件。看到右边我们可以搜索我们想要的插件。

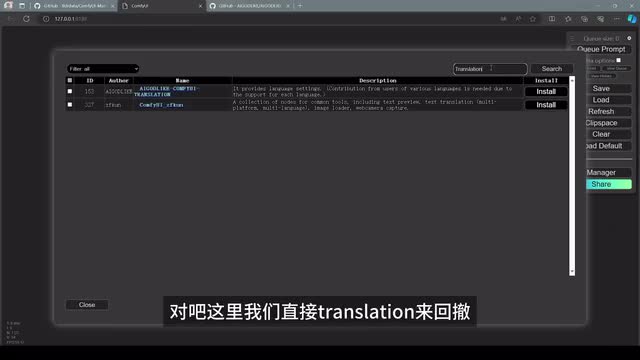

这里同样给我们列了一个插件列表,可以看到无数啊很多集合了conf u i用到的所有的插件之后我们这么安装。在右边呢我们搜索什么呢?搜索第一个要用的就是translation。啊,这样一个拓展是什么呢?这个translation它就是翻译嘛对吧?啊,界面翻译。那这样的话未来我们学习就很直观很方便的能理解它的一些界面应用对吧?那这里我们直接translation来回车可以看到这里有两个我们选择。第一个啊,我们可以看到它前面的一个前缀是这么一个a打头的前缀,对吧?那这边我们也可以看到这边是a打头的一个前缀,这个地址是没错的。我们点后面的安装啊install来安装一下。现在我们看后台可以看到,它同样执行了get to clone这一个命令啊,相当于它是用可视化的界面把我们执行了这样一个命令了,就这么简单。

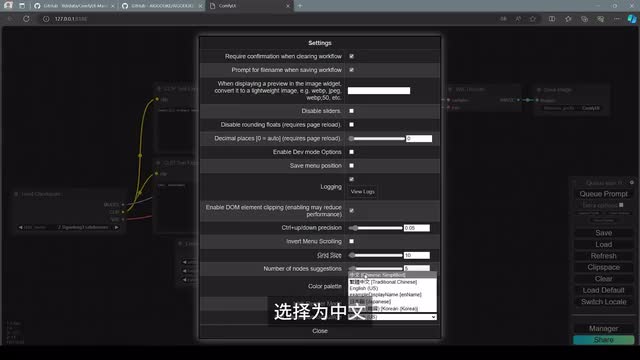

那现在呢已经安装完成,然后重新启动一下我们的咖啡u i全部这边也关掉,后台关掉,我们重新启动。接下来我们看右边这么一个菜单,右上角有个不起眼的小标志啊,这个齿轮就是设置了。我们点开设置,找到最下方有一个这个translation language,我们可以直接把我们想要翻译的语言选择为中文。ok现在可以看到它已经顺利的翻译成中文了。我们在这个小窗口下面可以看到有个切换语言如。那我们想切换回英文,只需要点击一下,那么它就成英文了。那在英文界面这里一样啊,还是这个位置,只要点击这个switch low code就可以切换回我们本地化页面了。

那么现在我们的汉化问题也解决了之后呢,我们在这里随便选择一个模型,可以看到它自动就识别到我们刚才设置的stable division的check point的主模型的文件路径了啊,这里我们还是选择一个曾经的一个模型,这就是一个简单的提示生成工作流。选择一个模型,我们直接点击右边的添加提示词队列,也就是生成我们的当前图像。点击一下。那这个流程它是用绿色框框选出来的节点,现在正在加载主模型,第一次加载可能会比较慢啊,那么加载完以后它会进行文本的输入。最后呢它会在这个采样器这边来进行一个综合的采样和图片的渲染。那么最后呢它会解码,解完码以后呢,会给到我们这边图像一个保存和生成。所以通过这样节点生成的方式呢,我们可以清晰的明白它的工作流程是怎么样一步一步一步一步的来完成,最终呢实现我们这个图像生成的。

那么这就是我们。解程序的安装,插件的安装以及程序启动的基本内容。那我们下一节将针对c v u i核心的生成部分,以及s d扩散模型的一些基本运算结构来进行仔细的分解。如果对c v i感兴趣的朋友,并且想循序渐进逐步深入了解的话,那千万不要忘了关注欧阳这一系列教程,那我们下期再见。

刺鸟图文助手

刺鸟图文助手