你好啊,朋友们,今天这期真是太必要了。很多朋友都在问我想让大模型学习到我的知识,怎么给他数据?哎,有人说你可以直接上传成文本了,某某某知识一千万,某某某知识二百万了。还有人说你可以用外接知识库r a g red,也还有人说你可以用微调find tuning what长文本提示rag微调到底是干嘛呢?有什么区别?我什么时候该用什么?哎,今天咱们就来用大家都能懂的方式聊聊大模型能力优化的几种常见方式。

现在就是点赞收藏的好时候。那第一种长文本提示,我们最经常用的拷贝一篇文章,或者是上传个p d f什么的,发给让他总结一下,或者是修改一下,或者说参考这个文章怎么怎么怎么样。那这个呢就是长文本提示。

那这篇文章啊其实就是跟我们的提示词这么一拼,哎,就发给大模型了。相当于我们考试的时候来做阅读理解。卷子上呢前面写了这么一大段文章,下面来了一句,请问作者想表达什么样的思想感情?那这一整段合在一起才是我们的问题。

如果是子上写的这个文章有多长,我们其实都是临场才看到的那卷子一收走,你肯定什么也记不住。那这个长文本数据呢也一样,它只能在你的这个对话窗口内有效,而且还不能超过它模型本身支持的上下文长度。比如说现在某大厂又说支持一千万长文本了,谁又支持多少多少token了。

那如果各大厂诚不欺我是真正的无损。长文本,那么也就是咱们可以给a i很长很长的上文来做阅读理解。但是呢a i得临时看这么长的东西,还快速的作答,这其实并不容易做到。

所以有的长呢还很鸡贼,用了另一个很常见的优化技术来假装无损长文本,那就是r a g rag检索增强生成。rag中给到a i的数据应该才是大家经常听到的知识库。这个知识库呢就好比我们写论文的时候吧,在图书馆里有一大堆书是学校给你准备的知识库,但是都没在你脑子里。

只有当你开始写某个主题的时候,你才会根据你的需要去把那些相关的书籍啊段落都找出来,参考和引用这个过程。并不会把图书馆所有的书都看了,甚至你拿回来的那几本书你都不一定全看了。你是按照跟你论文的相关性,在一个大的图书馆里搜索你要用的片段,参考参考引用引用,再给他组织出一篇论文出来。

那rag的知识库数据也是单独放在外面,提什么问你就去搜什么数据大模型也只是拿过来给你组织组织,哎,跟我们写论文很像啊,所以像我们看到的各种a i搜索。塔啊、flex啊那种都是用的rap。那第三种微调fine two。

其实在微调中说的数据啊,应该才是大家常常说的微数据。其实这个微字儿特别贴切,因为微调中的数据吧才是直接给大模型喂进去,就像喂饭一样。你喂了吧它得觉吧,它还得消化吧,最后还把你喂进去的饭得给变成肥肉。

那微调大模型呢也是把你喂进去的数据消化成了规律,固定在它的参数里。其实在微调之前啊,真正做大模型的厂商已经做过了一步,叫做预训练。这一步呢用了大量的算力数据让他有了基础知识,相当于啊先做了一个一二年基础教育。

那微调呢就是你作为一个高中毕业的学生上大学。假如说你选了一个医学专业,到大学里面就是四年给你微调一下,专门针对医学这个领域,给你一大堆知识和练习,让这个方向的知识和技能长到你的脑子里去。但是不是死记硬背啊,它是把接收到的信息压缩成了一种规律,把它记住了。

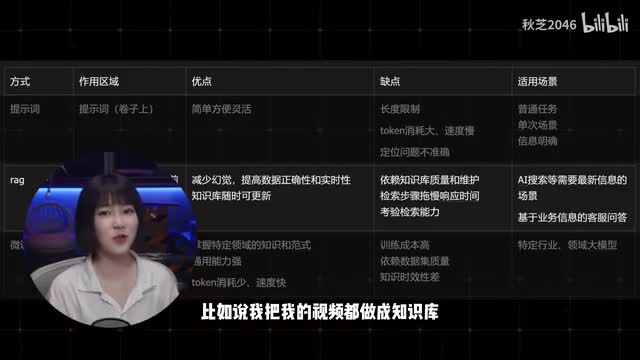

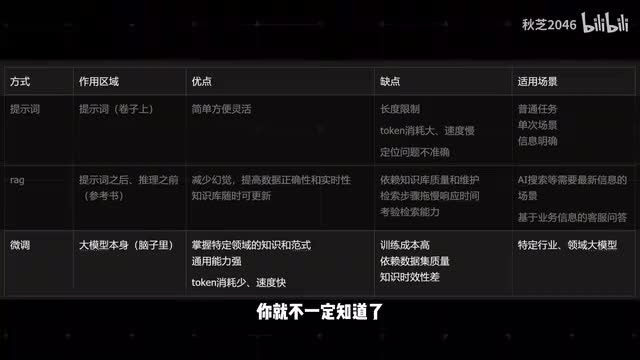

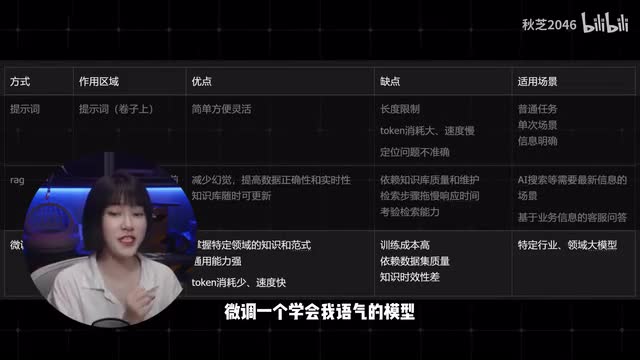

那你以后看见有人发烧咳嗽,哎,你一推测。这个大概率就是感冒了,甚至呢你还能沿着这个规律去推测一些你没学过的病症。好,那我们再来结合这张图,看看这三种给数据的方式分别是给在了大模型回答问题的哪个环节。

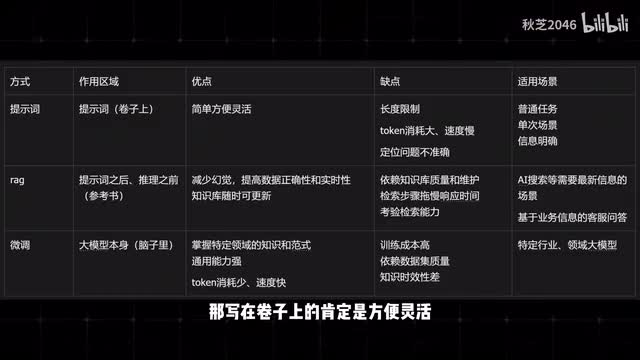

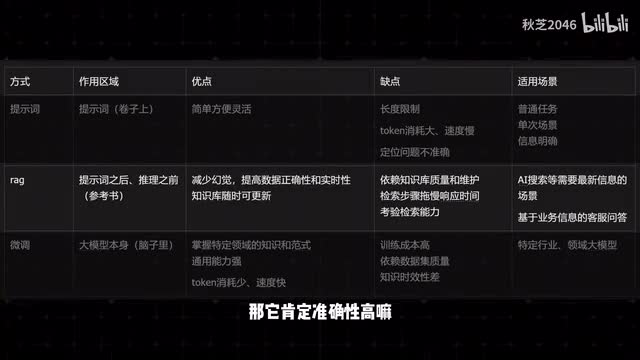

假设啊我们把大模型回答问题简化成三个部分,一个是我们的提示词,一个是大模型在推理,一个是它的回答。那第一种长文本提示呢是直接在提示词的部分,是写在卷子上。那第二种rag是在提示词之后和推理之前加了一步找资料,是写在了参考书里。

那第三种微调是直接在大模型本身,在上考场之前就先学进了脑子里。那么它们的优缺点是什么?适合什么时候用呢?你想啊那写在卷子上的肯定是方便灵活成本低嘛。但是啊它也长度有限,而且它太长了吧,对你的脑细胞答题时间也变长了,还一下子容易找不到重点。

所以它适合那种灵活的单次任务。比如说根据这篇新闻给我写了一篇短视频的文稿,那rag呢它可以临时查资料,那它肯定准确性高嘛,而且你多加几本书,它就能多回答更多问题。只不过缺点呢是你还得建个图书馆,非常的依赖。

你有哪些书,你的书是不是正经书,你要是找的慢呢,那也拖慢了答题速度。所以它适合做需要实时信息的问答。比如说我把我的视频都做成知识库,大家可以去问他本地大模型部署那期视频,说要下载什么来着?那微调呢学进脑子里了,当然适用的场景就多了,而且张口就来。

但是呢学习成本也很高,同时也取决于你上的什么学校,你学的好不好。而且如果又有什么新知识了,你就不一定知道了。另外呢记在脑子里的东西也不一定完全靠谱,因为即便你学好了,你上了考场也可以答错。

所以它们适合这个大模型啊,以后就准备长期干这个事儿。比如说我把我说过的所有的话都收集起来,微调一个学会我语气的模型以后呢,就让他来用秋芝的语气写一篇文章。真不错,以后的视频就这么出了。

当然大家也能看出来,这几种方法并不是非此即彼的。我们上了大学也得查资料,我们查了资料也得看卷子。这三种常见的提高大模型能力的方法都可以搭配来用。

好了,如果你觉得这一期内容对你有用的话,请在评论区告诉我。那后面的视频呢我就会正式的带大家以最简单的方式详细的讲讲rag的实现,带你快速的上手,实现自己的本地大模型加知识库绝对不难。好了,现在就是你点赞、收藏、关注的另一次好时机了,我们下次见。

刺鸟图文助手

刺鸟图文助手