小王子是我最喜欢的故事之一。那最近我尝试用a i把小王子和狐狸的故事片段做成了视频,那怎么做到的呢?这几天我把stable diffusion n为pa uno,亚马逊的bark q jji e等各种工具都玩了个遍,一顿操作猛如虎。那今天就来和和大家来分享一下,我是怎么用各种a i工具来做出这样的视频的。

现在用a i做视频常用的有三种法则,第一是给文字生成视频,最著名的工具就是松软了,但在这段时间应该也被它刷屏了,但这个工具还没发布,用不上其他的。比如说n n p p p p r r s这几个a i工具也都支持纹身视频。但是这种方式不可控,你不知道它会生成什么内容,而且人物很难做到一致性。

那第二就是转会视频生成视频,根据参考的视频进行风格的转移。其实大家看到的大部分比较酷炫的呀短片都是这种方式。那常用的工作流是用stable division来画关键帧,用app ids来做过渡。

那用这个方法的前提是得先有个参考的视频。第三是图片,视频根据静态图。片生成动态的视频,可以用的工具有runway皮卡pixels等等。

还有让人物说话的的工具,比如说d i d movie pass floor jin等等。那我用的是第三种,因为我要做一个比较完整的故事,我希望人物是固定的,画风是一致的那只有第三种方式可以做到,确定好做视频的方式,下一步就是最关键的分镜脚本。那分镜脚本简单理解就是把文字翻译成画面,把这个故事的每一个镜头都画出来。

那在动画片中,分镜头脚本也是原画师和动画师字画的主要依据。在我这个小项目中,分镜脚本就是视频的关键帧。决定这个视频是什么样子,从小王子的文本到视频画面的描述,需要包括场景描述、人物对话、景别和镜头运动。

那场景人物对话大家应该都懂,景别是什么呢?景别一般是远程中景、特远景交代环境,全景全身动作。那中景就是上半身的动作,近景就是人物的表情,那特写就是展示细节。灵活应用这些景别可以让你的画面更具有。

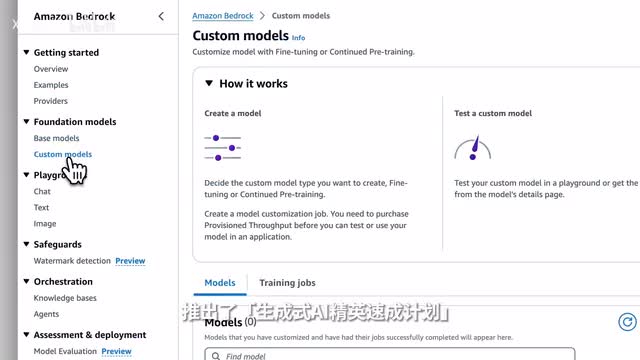

故事感从文本到分镜头脚本这一步,我用的是亚马逊barr c c g的的micro大模型,让a i来帮我完成这个步骤。那进入亚马逊的barrel控制台,真的可以调用t t n command lama stable diffusion各种大模型。我这边选择mystery大模型复制故事文本,让大模型把小王子和狐狸的这段文本改编成一个视频的翻译脚本,并按照一定的格式来输出。

micro生成的分镜脚本还是很不错的。在这个基础上我进行了一些删减和润色,形成了一个初步的视频脚本。那接下来就是镜头草图的绘制,因为这个步骤只是示意和草图,那我选择在亚马逊的barri r g中用stable的fusion来绘制。

一方面是因为生图比较快,二是调用比较方便,不需要搭环境、下载模型等各种繁琐的操作。想好每个镜头的画面,镜头的运动方式,各种修修改改之后,我就得到一个完整的分镜头脚本。那前期的准备工作已经完成了,接下来就是进入正式的绘图阶段。

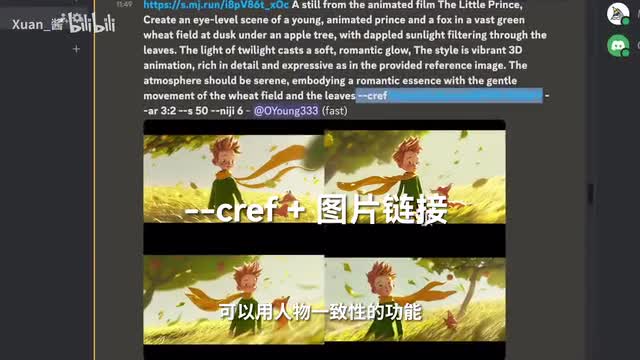

在这一步我会根据画好的分镜头来一张一张生成机械度更高,画风和人物保持一致的画面。因为视频是基于这些画面来生成的,我选择用生图质量更高的major ny做参考。最新版的journey在控制人物和风格的一致性上真的好了不少。

首先我们要先确定好画画风格,在这个风格为参照,在绘制生成的时候都加上style reference这个参数,来保证生成的图片画风是一致的那其次我们要先确定好角色,这里我们可以生成的文字和狐狸的角度做参考方面要先确定的的特写场景,在绘制的图中可以用用人勿一致的功能,在prom中加上character reference这个参数来保证画面中的人长得差不多。在绘制场景的时候,我们还可以用电图的方式给me jenny参参考叠加的未知性和角色一致性的功能,生成更优质的图片。比如说在绘制分镜头脚本的时候,有些人物的角度和姿势就可以给到major y做参考。

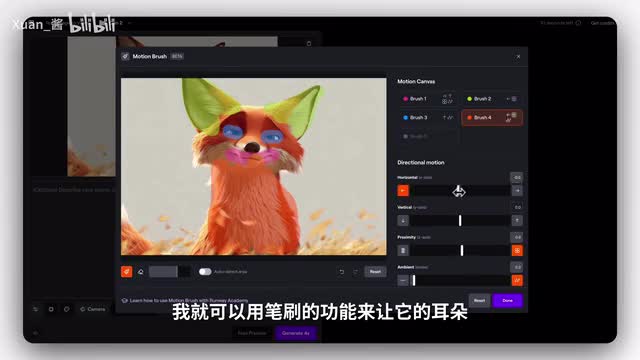

一张一张画完了所有的关键帧之后,接下来就来到了图生视频的环节。头像视频,我用了runway皮卡和stable video这三个工具来完成这个流程。人为支持motion brush笔刷来控制画面中特定位置的运动方式。

比如说你可以用这个功能来做人物的表情变化、喜怒哀乐等等,或者环境场景中的细小变化,比如说风吹草动、潮涨潮落等等。比如说我这个镜头,我想要让狐狸的面部表情动起来,我就可以用笔刷的功能,能让它的耳朵、眼睛、嘴巴、毛发等都动起来。此外,rv还支持镜头的推拉、摇、平移、旋转等多种运行的方式来模拟真实拍摄环境中的镜头运动。

通过不同的运镜方式可以增强画面的丰富性。那搭配motion brush和镜头控制可以做出很不错的镜头。少部分对话的镜头我用的是p卡那皮卡有一个对口型的功能,上传人物照片或者视频之后,点击你的lip sync,可以在这个镜头中输入人的方式来选择配音的功能,或者上传音频文件可以生成对应的型的视视频。

tam还在这个t o p p video走在一些。绕的镜头上表现非常不错。比如说这几个镜头都是用stable video来生成的。

如果生成的视频清晰度比较低,我会在cap cut中增强一下清晰度,那这个工具是完全免费的。整个涂成视频的过程非常的繁琐,因为生成的效果不太可控,需要经过反复的调试才能够达到一个比较好的效果。那把所有的图片都生成视频之后,最后来到了配音和剪辑的环节。

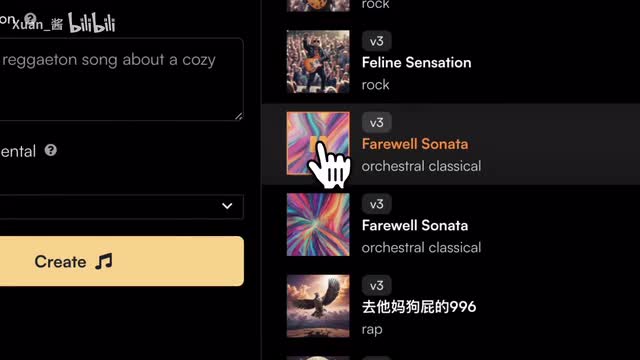

背景音乐我用的是最近很火的s u n n w,输入简单的prom就可以生成你想要的配乐。比如说我想要生成一段关于离别的悲伤的旋律,它生成的效果很不错。加上音效和剪辑之后,我们可以来看看最终的效果。

come and play with me. i, i, i, i play with you. i am not tamed. what does that mean? tame means to establish ties to me. you are just a little boy like a hundred thousand little boys. i do not need you, and you do not need me to you. i am just a fox like a hundred thousand foxes, but if you you tell me, then we shall need each other. no, are you gonna cry? my team, you have done no good, good. it, it, it is done me good because of the color of the weed fields. let me make you a present of the secret. it is only with the heart that one can see rightly. what is essential is invisible to the eye. 虽然整体上还是非常的粗糙,但有些个别镜头的画面我觉得已经不错了,算是能看的程度吧。那尝试了大部分a i工具之后,我现在就是非常期待solo的上线了。最后特别感谢亚马逊云科技赞助本期的视频。

如果你是a i爱好者或者是独立开发,可以在亚马逊的b e r r o g中一站式调用各种大模型,还可以上传自己的知识库,做符合个人需求的智能体等等等等。亚马逊云科技最近还为a i爱好者推出了生成式a i基因速成计划,提供了一系列的a i课程最佳使用场景和a i工具的应用示范。如果你想系统的了解如何应用大模型平台训练与部署大模型,以及如何打造生成式a i应用,那一定不能错过。

那以上就是本期的全部内容,这里是宣讲,我们下期见。拜拜。

刺鸟图文助手

刺鸟图文助手