chat g p t的工作原理是什么?最近几个月有不少的科普视频已经出来了,有些相对比较深入浅出的视频把chat g p t的训练比喻成一场词语接龙的游戏。说chat g p t其实就是通过大数据训练,让电脑学会了根据上文的内容接下一个字。这个训练过程就像你想教会自己完全没有学过古诗的儿子背诵鹅鹅鹅。不给任何提示,让他自己先猜。先给第一个字额,问第二个字是啥?鸡一个大逼豆子再来,鸭一个大逼豆子再来。额,对了,现在前两个字是额额。第三个字是啥?鸡一个大逼豆子再来,鸭一个大逼豆子再来。额,对了,现在前三个字是额额额,第四个字是啥?于是在吃了无数个大逼兜子之后,儿子终于学会了鹅鹅鹅,曲项向天歌这种方法不能说完全没效果吧,就是有点费手。

如果你用这种方法教儿子学古诗,就算教不出神经病,也只能教出一个背诗机器。他理解不了诗的美,也创造不出新的诗句。所以这种对chat g p t的解释不能说不对吧,但也有点太简单了。它很容易让人觉得chat g p t就是一个死记硬背和暴力穷举的产物。但暴力穷举能真正创造出语言吗?并不能。大刘同学有一篇小说叫做诗云,说的就是一个靠暴力穷举写诗的故事。小说里有一个点,歪了科技树的神级文明外星人,为了写出超越李白的诗,干脆把所有的汉字都拿过来,靠暴力穷举出所有的组合。你不是诗写的好吗?我把五言和七言诗,所有可能的汉字组合都给你。

这里面一定包括你所写过的所有的诗,甚至也包括比你好的诗。好吧?为了存储下这所有的诗,你猜他用了多大的存储器,把整个太阳系的质量用光了,才建立了一个量子存储器,存储了所有的可能。我说这个外星人把科技树点歪了,是因为它已经可以用纯能来制造物质了。在人工智能领域的发展却无限接近于零,现在是二零二三年,刚刚发展到零点七级的地球文明还没有突破可控核聚变。但人工智能的绘画工具已经能够画出惟妙惟肖的小姐姐,而chat g p t更是可以同时和几亿人谈笑风生。就算暂时还写不出超越李白的诗,但作诗水平吊打一般人类也不成问题了。而我们并不需要太阳系那么大的存储器。所以如果语言接龙是一种训练方法,chat g p t也一定是通过这种方法掌握了更高维度的规律,从而提高了学习效率。

就像某人吃了两个大逼兜子之后,再猜第三个字的时候,不可能还去猜鸡一样。在训练过程中,一种能够被电脑所理解的语言结构被呈现了出来。正是这种对结构规律的把握,才让chat g p t真正学会了人类语言。那么这种结构是什么呢?只有理解到这一层,我们才能清楚地回答下面的这些问题,chat g p t到底是如何理解人类语言的?这种理解方式与我们的思维有什么共通之处在这条路上狂奔下去,ai会最终涌现出智能吗?这种发展趋势对当下的我们以及未来的人类文明会有哪些影响?今天我们就展开来跟大家谈一下。正片开始。大家好,这里是新石器公园。chat g p t是如何理解人类语言的?要回答这个问题,我们首先需要知道计算机是如何记录现实世界的。计算机的底层是二进制,我们现实世界的所有问题如果交给计算机处理,其实最终都是把它转化成了数学问题。

比如英语的二十六个字母,我们可以找五十二个数字来代替,二十六个数字表示大写,二十六个数字表示小写。我们要存储一幅画,我们可以把每个像素的颜色表示为红绿蓝r g b三种颜色的组合,而每一种颜色都可以表示为零至二五五的数字。比如红色,r零表示最浅的红色,二五五表示最深的红色。于是一幅画在电脑中就变成了一大堆数字的组合。但是这种表示方法有个问题,电脑并不能把数字和它实际表示的东西建立起联系。在非人工智能的时代,电脑只是我们存储和处理信息的一种工具。就像存储和处理食物的冰箱和锅一样,他们并不需要认识冰淇淋和鱼香肉丝,使用它们的人认识冰淇淋,知道怎么做鱼香肉丝就可以了。但是人工智能时代,我们需要电脑自己处理现实世界的信息。

图像识别需要看到照片就能识别一个人,而自然语言理解需要看到一句话就能够理解他所说的意思。电脑如何才能做到这一点呢?至少得需要两步,第一步叫做向量化,第二步叫做信息压缩与特征提取。先看向量化,什么是向量化?简单来说就是把你要表示的东西变成一组数字的组合。比如我们要表示一个人可以用这样的一组数字,零幺八零七五二零。看不懂,我简单解释一下你就明白了。第一个数字表示性别,零是男一是女。第二个数字表示身高,第三个数字表示体重,第四个数字表示年龄。现在你知道这一组数字表示的就是身高一米八零,体重七十五公斤,年龄二十岁的男性。

什么?你觉得这样的表示太简单,没有把握你的优秀特征?没问题,我们可以增加维度啊,比如你的三围、体脂率、肤色、发色、爱好、学历、收入、城市、你对新石器公园的喜欢程度等等。所有这些都可以表示成数字。维度越多,我们对你的定义就越准确,通过这些维度筛选出来的人跟你的相似度就越高。那么为什么要向量化呢?有两个原因,第一表示成数字电脑才能够方便处理。第二向量化以后的空间结构展现出了一定的规律。第一点就不用解释了,我们看第二点,为了表示简单,我们只画两个维度,身高和体重。你看到了吗?在这样的一个坐标里,幺八零七五在这个位置,所有和这个点接近的位置都是体型和你相似的人。而我们增加更多的维度,衡量标准就越多。

在高维度的坐标系里,我们就能够更多的通过空间关系理解每一个人的特征。词语也是一样的,只不过它更抽象,表示它的维度也更不容易被总结出来。但请你相信,如果我们把它们同样放在一个很高维度的坐标里,那么你就会发现意义相近的词语,它们的空间可能就会更近。比如美和大,可能从雌性维度上它们都是形容词,从贬义褒义上它们都是褒义,从使用场景上他们经常一起出现。因为总有人说大就是美大就是美。当然还有各种我们猜测不出来的维度,所有这一切维度让他们在一个高维坐标里处在了比较近的距离。除此之外,因为向量是可以计算的,就像我们普通的数字一样,我们可以相加、相减和相乘。当我们把词语放到向量空间中后,我们发现神奇的事情发生了。

国王这个词减去男人再加上女人,得出的向量居然和女王或者王后的位置非常接近。这说明什么?这说明在一个合适维度的坐标中,词语之间的空间关系反映了他们现实世界的实际关系。是不是相当amazing?好吧,这件事情说起来很简单,但实际上可能很难。前面说了,我们需要把词语放到一个合适维度的坐标中,还要能正确的标注出每个词语在这个空间中的位置,这种神奇的事情才能发生。但是怎么找到这些维度,怎么找到词语的空间位置呢?这就是人工智能要干的事情了。比如我们预先准备一个五十维度的坐标,准备放一万个词,先把这一万个词随便扔到坐标里。对,就是随便扔每个慈爱在哪里在哪里,说的专业一点点,就是随机产生每个词的向量,然后到语料库中随便拎一句语料出来,让电脑玩词语接龙,找到第一个词和第二个词,把它们的向量拿过来一通计算,看看第二个词跟在第一个词背后的概率有多大。如果算出来概率很大,那你蛮走运的,说明这两个词在坐标里的位置很合适。

如果概率很小,说明一开始随便放的位置并不合适,怎么办呢?一个大逼兜子回去给我调整位置,然后电脑把词的位置再调一下,再回来算还不行,一个大逼兜子再回去调整。说到这里你可能要说了,这和一开始的儿子背诗有啥区别?还不是大逼兜子吗?客官有所不知。因为向量是可以计算的,所以我们就可以知道每次计算出来的数和正确结果差距有多大,这个就是损失函数。我们的训练目的就是要让这个差距越来越小,这是有数学方法可以逼近正确结果的,这个过程叫做收敛,也就是追求大鼻兜子越大越轻,具体不展开了。你就知道在向量空间下训练,不断吃大鼻兜子的电脑是知道往哪个方向改进的就行了。真想刨根问底,可以去看我们人工智能系列的第一期。就这样在吃了不少大鼻兜子以后,电脑终于调整好了词的位置。接着我们把第三个词加进去继续训练。

然后第四个词、第五个词就这样在给了足够多的语料以后,这一万个词都训练了好多遍了。于是每个词都找到了自己在坐标里的正确位置,词的向量化工作就结束了。这个工作不新鲜了,十年前的二零一三年,谷歌就发布了著名的what white模型,看名字你就知道了,就是专门把词向量化的。但是既然词向量已经能够帮助电脑理解每个词的意思,为什么直到十年以后我们才看到了自然语言理解的春天?那是因为到现在为止,我们只干了第一步,还有刚才提到的第二步没有做,那就是信息压缩与特征提取。没有做特征提取就相当于没有找到正确的规律,引用错误的规律去训练电脑,那么电脑最后帮你找到的词向量也就是错误的。也就是说这些词其实并没有找到自己在向量空间中的正确位置。傻眼了吧?不着急,我们继续看。现实世界的信息量是非常大的,为了理解和记忆它们,我们不可能把所有的信息都拿来处理。

这不仅非常浪费时间,而且没有办法让我们抓住重点。我们的大脑在处理信息的时候也是层层压缩和过滤的,只有最重要的信息才会进入我们的意识进行处理。图像识别之所以能够首先在人工智能领域取得突破,就是因为他首先找到了提取图片特征的方法,也就是卷积神经网络。前几年大行其道的cnn具体原理不展开了,想了解的可以去看我们的人工智能系列第三期。而语言虽然是我们人类创造的,但是一开始我们却一直找不到提取语言特征的正确方法。多年以来人类一直在用的叫做循环神经网络r n n。它的基本训练方法跟咱们前面说的差不多,就是把前面多少个词作为输入,让电脑去猜下一个词。这个方法下,离下一个词越近的词权重就越高,而越远的词影响就越小。

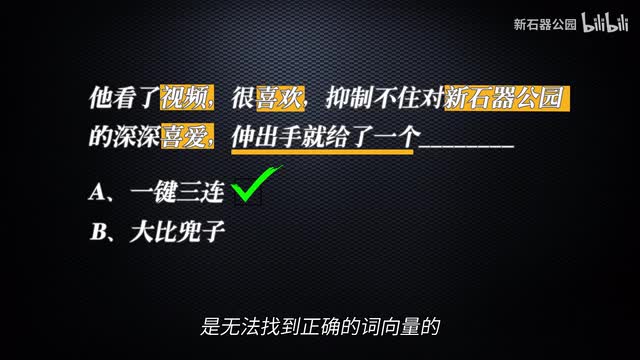

这不仅让电脑会遗忘掉太远的词,而且很多时候提取不出正确的特征。比如下面这句话,他看了视频很喜欢,抑制不住对新石器公园的深深喜爱,伸手就给了一个后面是什么?a一键三连,b大逼兜子。很显然,答案是a而决定你选a的是哪些词?很明显是前面的视频喜欢新石器公园和喜爱而离这个词最近的伸手就给了一个,反而最没有帮助。所以按照顺序去提取特征,让电脑去训练,是无法找到正确的词向量的。那么怎么解决这个问题呢?这就需要介绍我们的重量级选手了,ai发展史上跨时代的模型,谷歌人工智能的最后辉煌,未来通用人工智能的老祖宗chat g p t里的那个t transformer。二零一七年谷歌提出了transformer模型,创造性地提出了一种叫做自注意力机制的方法,解决了自然语言的特征提取问题。因为模型有点复杂,而之前机器翻译那一期已经介绍过了,我们就不展开说了。有想刨根问底的小伙伴可以去看那一期。

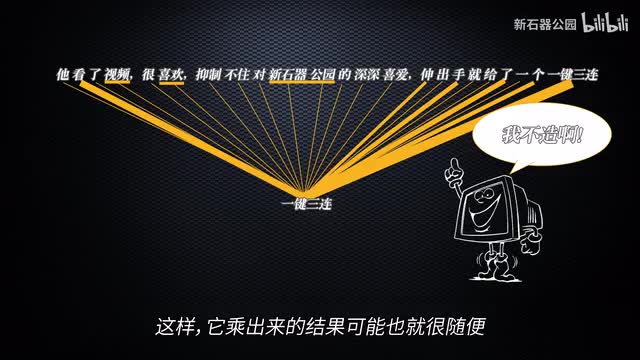

简单来说就是让句子里的词自己去和句子中所有的词做向量相乘,乘出来的结果再去做训练。比如上面这句话中的视频,喜欢新石器公园等等词与正确答案一键三连的相关性更大。那么如果向量正确的话,这几个词与一键三连乘出来的结果应该更大。电脑不知道啊,所以他一开始只能随便给向量,这样他乘出来的结果可能也就很随便,怎么办呢?大鼻兜子伺候。于是最终在这种训练下,电脑自己就能找出句子接龙中如果要猜出正确的词,哪些词的权重更高。这就和我们对这个句子结构的理解非常接近了。有了transformer自注意力机制的加持,我们终于可以成功的对语言进行压缩和特征提取了。在正确的特征提取下进行训练,我们就可以让电脑成功的做好向量化了。

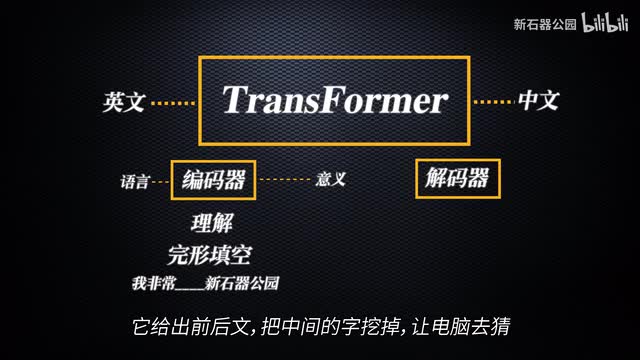

我们来看看transformer其后的发展。因为transformer是一个语言翻译模型,所以整个模型是由编码器和解码器两部分组成的。而这两部分的训练方法略有不同。编码器考验的是对语言的理解,所以它使用的训练方法是完形填空。它给出前后文,把中间的字挖掉,让电脑去猜。而解码器是要根据意思翻译成另外一种语言,所以它考验的是语言的生成,训练方法是词语接龙。后来谷歌和open a i分别拿走了编码器和解码器,搞出了自己的语言模型。谷歌的重在语言理解叫做bert。

open a i的重在语言生成就是g p t,也就是chat g p t的前身。看到这里你可能明白了,chat g p t本身其实就是一个语言模型。它被制造出来的根本目的并不是解决实际问题,而是怎么把话说得漂亮。而他把话说漂亮的诀窍其实也并不高深,说白了就是根据上文的内容去推测下一个词应该是什么,然后把这个词加进去,继续推测下一个词是什么。在不断的推测过程中,把词连成句子,他只关心说出来的话像不像人话,并不关心是不是正确。之所以我们在很多时候觉得他说的很有道理,只是因为他看过太多的语料库,在他所有的训练语料中,正确的说法是概率最大的那种而已。那么这样一种终极目标是把话说漂亮的a i模型是如何成为如今大杀四方的通用人工智能雏形的呢?最重要的原因就是open a i赌对了方向。open a i创立之初的愿景就是要做通用人工智能,但是如何能够做出通用人工智能,其实是没有答案的。

在几年前,人工智能领域还是各种专业人工智能的天下,从业者基本上都是聚焦在一个细分的领域,比如围棋,比如图像识别,比如玩游戏、设计模型、标注数据、进行训练,然后获得一个好成绩,名扬天下。open a i一开始也搞了几年游戏,直到transformer出来才选定了自然语言理解作为方向。阿布私下认为这是一个非常正确的选择,因为语言才是理解整个人类社会最重要的工具。人类的几千年文明史,几乎所有的显性知识,它的载体都是语言,而人类相互之间的交流,最重要的渠道也是语言。所以如果电脑能够理解语言,就相当于它获得了理解整个人类文明成果的能力,也获得了和人类无缝交流的能力。所以,要产生通用人工智能,语言一定是最初的突破口。但近几年transformer的徒子徒孙们也有很多,国内国外都有很多以transformer为模板进行优化的模型。为什么最终只有open a i走了出来?因为只有open a i是冲着通用人工智能去的。

在bert和g p t一出来的时候,其实bt的各方面性能是完全吊打g p t的。这时候open a i面临两种选择。第一,根据特定场景优化模型的算法,提升模型的性能,搞出一个性能更高的模型。第二不够好,肯定是因为向量空间不够大,不够精确。因此增加训练层数,增加词向量的维度,增加训练数据。也就是说增加参数数量和训练数据,搞一个更大的模型出来。open a i选择了后者,他们笃定通用人工智能需要泛化到更多的场景,因此需要更大的参数和更大的数据量。果然又赌对了,在参数规模达到一千亿量级的时候,神奇的现象产生了,这种现象叫做涌现,一些语言模型本来不应该具备的能力忽然产生了。

自此open a i一路高歌猛进,和其他公司彻底拉开了距离。二零二二年底chat g p t问世,技惊四座。后面的故事大家都知道,那么这种涌现是不是会产生意识呢?chat g p t及其后代又会对人类文明产生什么样的影响?时间关系,本期没有办法展开了,我们下期继续讲,关注一下不迷路哦。这里是新石器公园。我们关注一切可能影响人类未来的科学和技术,并试图带大家一窥底层的原理。如果你喜欢本期视频,欢迎点赞、投币加收藏。如果你对航天、人工智能、信息数据、生命科学、人机交互以及未来感兴趣,欢迎关注我们。本期就到这里,很快回来,下次再见。

刺鸟图文助手

刺鸟图文助手